AutoTune, jeśli przetłumaczysz angielski termin Auto Tune, oznacza pewien rodzaj automatycznej regulacji. W muzyce, w większości przypadków, termin ten jest rozumiany jako środek przetwarzania wokalu pod kątem korygowania niewłaściwie śpiewanych nut. Z grubsza rzecz biorąc, Avtotyun jest dokładnie tym, czego większość wokalistów używa, aby doprowadzić śpiewaną imprezę do normalnego słuchania. A potem większość "popsovikov", który śpiewał pod fonogramem, zwykle wykonuje partię wokalną, jak się okazuje, nie jest w stanie. Naturalnie, w studiach, które nadają wokalom brzmienie komercyjne lub profesjonalne, stosuje się programy equalizerów.

"Avtotyun" jest tym, co robi wtyczka?

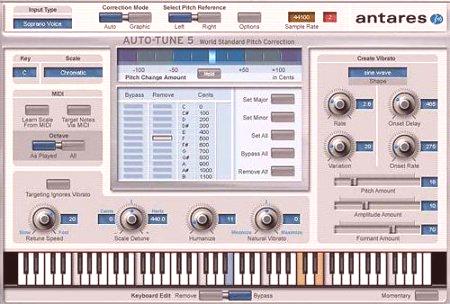

Jednym z najbardziej popularnych jest program Antares Auto-Tune, zaprojektowany jako VST formatach wtyczkę, RTAS i DX, który może być używany w każdych DAW-Studio obsługuje ten format (FL Studio, Cubase, PreSonus Studio One, Cakewalk Sonar i itp.).

Proces autotyune sam w sobie jest wyrównaniem wokalu na nutach w wybranej tonacji. Prawie wszystkie programy tego typu pozwalają na ustawienie początkowe warunki w rozpoznawania głosu i jego tonu (mężczyzna, kobieta, dziecko, sopran, bas i tak dalej. D.).

Zasady ogólne programów wyrównywania wokalu

„Avtotyun” Russian jako wtyczki podłączonej do badań stwierdzono mało prawdopodobne, aby odnieść sukces. Jednak nawet przy minimalnej znajomości języka angielskiego, aby zrozumieć moduł oprogramowania Antares nie będzie działać.

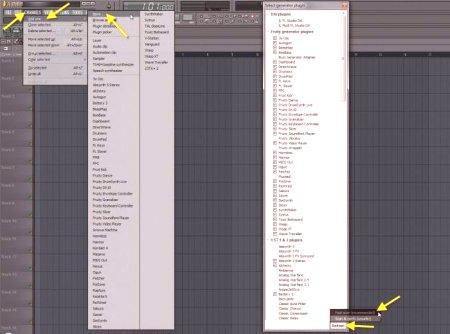

Podstawą powinna FL Studio i będzie budowaćz działań przeprowadzonych w tym środowisku oprogramowania.

Autotune dla FL Studio

Zacznijmy od tego, że wokal jest już nagrany (albo w samym programie, albo w innym edytorze).

Po zainstalowaniu wtyczki w katalogu programu VST, należy ją aktywować poprzez wyszukiwanie (szybka aktualizacja dodatków szybkiego skanowania). Następnie przeciągając lub klikając prawym przyciskiem myszy, należy dodać go jako efekt do odpowiedniego śladu na konsoli, po czym można zacząć decydować, jak korzystać z samochodu.

Podstawowe ustawienia i parametry Antares AUTO-TUNE

Przede wszystkim należy określić, który typ wokalu odpowiada zapisanej ścieżce dźwiękowej. Aby to zrobić, użyj przycisku Input Type. Następnie powinieneś słuchać wokali bez przetwarzania z domyślnymi ustawieniami. Jeśli nie włączy się "na żywo", będzie musiał ustawić klucz (Key) i rodzaj użytej sekwencji harmonicznej (fad), aby dokładniej określić przesunięcie muzyki w jednym lub drugim kierunku. Na przykład w sekwencji chromowania C-dur.

Podczas edycji możesz użyć ustawień takich jak Humanize, innymi słowy, dodać realistyczną wydajność (jest to opcjonalne, ale nie przesada, lub efekt chóru, a nawet flanger). Zasadniczo można zastosować ustawienie automatyczne, ale sama wtyczka ma specjalny edytor graficzny, w którym wszystkie etapy dopasowywania wokali mogą być wykonywane ręcznie. Dźwięk będzie wyraźnie lepszy.

Alternatywa w postaci aplikacji Melodyne

Aleoryginalny Antares Avtotyun jest po prostu najprostszym sposobem obsługi strony głosowej, która, mimo że jest dość łatwa w użyciu, ma jednak wiele istotnych wad. Jak możesz go z tym wyciągnąć? Cóż, ćwierć tonę, cóż, pół tony na maksimum (obok nut są), nie więcej. Program w rzeczywistości dla szerszych zakresów nie jest obliczany.

Ale kiedy wymagana jest profesjonalna edycja, prawdopodobnie pojawia się tu najpotężniejsze nowoczesne narzędzie o nazwie Melodyne (jest instalowane zarówno jako wtyczka, jak i niezależna samodzielna aplikacja). Jest o wiele więcej możliwości niż Antares. Możesz łatwo przenosić utwory wokalne na notatki, bez obawy o zmianę jakości dźwięku (oczywiście w rozsądnych granicach). Oprócz przeciągania wokali można zastosować specjalne funkcje niwelacji nut (Quantize), kilka algorytmów automatycznego przetwarzania do wyboru, korekta tempa, edytor muzyki i dźwięku, wbudowane efekty i wiele innych.

Alternatywa dla wszystkich dostosowań

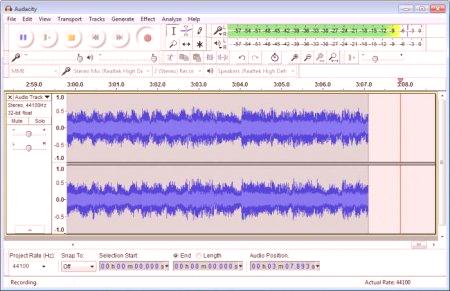

Aby osiągnąć wysoką jakość dźwięku w tym samym edytorze FL Studio nawet przy użyciu wtyczek takich jak Antares czy Melodyne nie będzie działać. Przynajmniej produkcja i postprodukcja powinny być wykonywane przy użyciu zupełnie innych aplikacji na wyższym poziomie. Edycja dźwięku będzie musiała zostać wykonana za pomocą edytorów takich jak Sound Forge czy Audition. W programach tego typu edycja jest ograniczona możliwościami samych aplikacji tylko dlatego, że nie reprezentują ścieżki w formie fali, ale to jest plus.

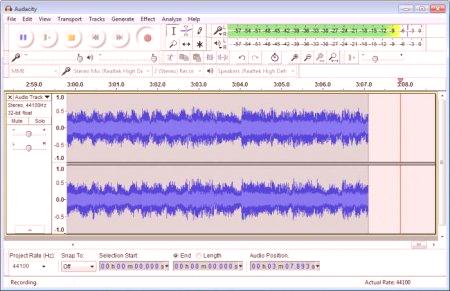

Każdy producent powie, że jest w fali reprezentacji audio i jest to konieczneedytuj Jeśli nie wiesz, jak to zrobić, możesz użyć nawet najprostszych ustawień dźwięku. Aby rozpocząć, należy wziąć pod uwagę narzędzie Audacity. Jest dość łatwy w użyciu. Ale wraz z jego rozwojem możesz zacząć studiować poważniejsze rzeczy. Ponownie, trzeba zobaczyć różnicę między pracą edytorów fal i prostowników, takich jak wyżej wymienione narzędzia. Nawet w reaktorach typu Adobe Audition w formie fali można otworzyć dowolną ścieżkę i dowolny format. Ale początkowo regulacja wysokości dźwięku opiera się na nieco innych zasadach, które, nawiasem mówiąc, wykraczają poza możliwości standardowych wtyczek.

Zamiast wyniku

Pozostaje jeszcze dodać, że kwestia, w jaki sposób zrobić samochód w ogólnym rozumieniu zachodzących procesów, i niezależnie od używanego oprogramowania, nie jest tak skomplikowana. Na tym i stworzył takie zautomatyzowane narzędzia. Kolejna rzecz - śpiewać tak, że istnieje minimalna ingerencja (jak to jest wymagane w każdym przypadku), które zostaną zredukowane nie wyrównać prawidłowo pod względem muzyki wokalnej śpiewanych, ale tylko do zmiany w całkowitej objętości lub przy użyciu efektów zachodzących na siebie. A programy przedstawione powyżej, jak wielu z nich nie chciały, nie działają w czasie rzeczywistym, to znaczy, że występy koncertowe z natychmiastowym efektem "ciągnięcia" nie pasują. Dla tych koncertów będzie musiał korzystać z programów hybrydowych, które działają w kombinacji wnioskodawcy, reprodukowane w tym okresie czasu i sygnału wyjściowego. To nie zawsze działa poprawnie.zwłaszcza jeśli weźmiesz pod uwagę opóźnienie między sygnałem wejściowym a wyjściowym, na przykład na koncercie z różnicą w dźwięku monitorów na scenie i portalu źródłowego, co może dać dźwięk hali.